Apple steht vor einer juristischen Herausforderung, die das Unternehmen teuer zu stehen kommen könnte. Eine Klage über 1,2 Milliarden US-Dollar wurde eingereicht, weil der Tech-Gigant seine Pläne zur Erkennung von Kindesmissbrauchsmaterial (CSAM) in iCloud-Fotos aufgegeben hat. Diese Entwicklung wirft ein Schlaglicht auf die komplexe Debatte um Kinderschutz und digitale Privatsphäre.

- Apple wird wegen Aufgabe der CSAM-Erkennung für 1,2 Milliarden Dollar verklagt

- Kläger argumentieren, dass Apples Entscheidung Opfern weiteres Leid zufügt

- Apple betont weiterhin sein Engagement für Kinderschutz ohne Kompromisse bei der Privatsphäre

Die Klage, die am Samstag in Nordkalifornien eingereicht wurde, vertritt potenziell 2.680 Opfer. Sie argumentiert, dass Apples Entscheidung, die angekündigten Kinderschutztools nicht umzusetzen, die weitere Verbreitung schädlicher Inhalte ermöglicht und den Opfern anhaltenden Schaden zufügt.

Der Ursprung des Konflikts liegt im Jahr 2021, als Apple Pläne zur Implementierung einer CSAM-Erkennung in iCloud Fotos ankündigte. Diese Initiative stieß jedoch auf erheblichen Widerstand von Datenschützern, Sicherheitsforschern und politischen Gruppen. Die Kritiker argumentierten, dass die Technologie potenzielle Hintertüren für staatliche Überwachung schaffen könnte. Infolgedessen verschob Apple das Projekt zunächst und gab es später ganz auf.

Apple begründete seine Entscheidung damit, dass eine universelle Überprüfung des privaten iCloud-Speichers der Nutzer erhebliche Sicherheitslücken schaffen würde, die von böswilligen Akteuren ausgenutzt werden könnten. Zudem äußerte das Unternehmen Bedenken, dass ein solches System einen problematischen Präzedenzfall schaffen könnte: Sobald eine Infrastruktur zur Inhaltsüberprüfung für einen Zweck existiert, könnte der Druck entstehen, sie auf breitere Überwachungsanwendungen auszuweiten.

Die Hauptklägerin, die unter einem Pseudonym auftritt, berichtet von andauernden Benachrichtigungen der Strafverfolgungsbehörden über Personen, die wegen des Besitzes von Missbrauchsbildern aus ihrer Kindheit angeklagt werden. Die Klage argumentiert, dass Apples Entscheidung, die angekündigten Sicherheitsmaßnahmen nicht umzusetzen, die Opfer zwingt, ihr Trauma immer wieder zu durchleben.

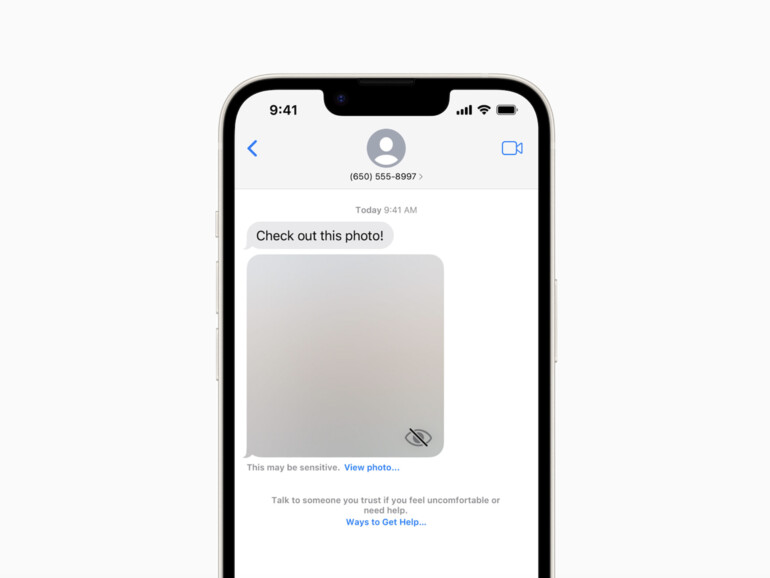

Als Reaktion auf die Klage betonte Apple-Sprecher Fred Sainz das Engagement des Unternehmens im Kampf gegen Kindesmissbrauch. Apple arbeite "dringend und aktiv an Innovationen zur Bekämpfung dieser Verbrechen, ohne die Sicherheit und Privatsphäre aller unserer Nutzer zu gefährden". Das Unternehmen verwies auf bestehende Funktionen wie Communication Safety, die Kinder vor potenziell unangemessenen Inhalten warnt, als Beispiele für seine fortlaufenden Bemühungen zum Kinderschutz.

CSAM steht für 'Child Sexual Abuse Material' und bezeichnet Bilder oder Videos, die sexuellen Missbrauch von Kindern zeigen. Die Erkennung solcher Inhalte ist ein wichtiges Werkzeug im Kampf gegen Kindesmissbrauch. Technologieunternehmen stehen vor der Herausforderung, CSAM zu bekämpfen und gleichzeitig die Privatsphäre ihrer Nutzer zu schützen.

Diese juristische Auseinandersetzung verdeutlicht das Spannungsfeld zwischen Kinderschutz und Datenschutz, in dem sich Technologieunternehmen bewegen. Es bleibt abzuwarten, wie das Gericht die Argumente beider Seiten bewerten wird und welche Auswirkungen das Urteil auf zukünftige Kinderschutzmaßnahmen in der Technologiebranche haben könnte.

Diskutiere mit!

Hier kannst du den Artikel "1,2 Milliarden Dollar: Massive Klage gegen Apple wegen aufgegebener Kinderschutz-Pläne" kommentieren. Melde dich einfach mit deinem maclife.de-Account an oder fülle die unten stehenden Felder aus.

reine Geldschneiderei

Seh ich auch so.

Und das aus einem total lächerlichen Grund, dass eine Firma eine Entwicklung aufgibt. Firmen geben hunderte Entwicklungen auf, was deren eigenes Recht ist. Apple hat gegen nichts verstoßen und keinerlei Rechte verletzt.

Als nächstes kommt der Einbeinige und verklagt Apple weil die keine Beinprotese entwickeln.

Und der Einäugige verklagt Apple, weil die Vision ihm keine räumliche Darstellung liefert.

Mal ganz ehrlich, tut mir ja leid was ihr passiert ist, aber mit so einem Trauma zu meinen seinen Frust bei anderen rauszulassen geht nicht.

Geht garnicht. Die Klage hat keine Grundlage. Reine Geldschneiderei.

apple wurde doch genau wegen dem csam technik in die ecke gedrängt aus den gründen des „ datenschutz „ und dem das sie private bilder scannen

Wie zum Lesen ist, soll die angedachte Initiative auf erheblichen Widerstand von Datenschützern, Sicherheitsforschern und politischen Gruppen gestoßen sein. Somit kann man davon ausgehen, dass dies aus Datenschutzgründen sich nicht umsetzen ließ.

Nach meinem Verständnis sind iCloud Fotos auch nicht öffentlich einzusehen, daher erscheint diese Argumentation nicht schlüssig zu sein.

Bei dieser Argumentation wäre dann der nächste logische Schritt, auch die Hersteller von Datenspeicher (Festplatten) zu verklagen und die Hersteller von Kameraobjektiven, die solche Aufnahmen nicht verhindert haben.

Wo kommen wir dann hin, die Gesetzgeber scheinen bereits jetzt viel zu viel zu regulieren.

Warum werden dann nicht die Hersteller von Schusswaffen zur Verantwortung gezogen, wenn mit deren Waffe ein Mord verübt wird?